Deepfake

Новая реальность

Новая реальность

private Monom copy(Monom pointer) {

123456Polynom tail = new Polynom(0, 0);

123456Monom polPointer = tail.head;

123456while (pointer != null) {

123456123456if (checkZero(pointer.kf)) {

123456123456tail.add(pointer.p, pointer.kf, polPointer);

123456polPointer = polPointer.next;}

pointer = pointer.next;}

return tail.head.next;}

123456Polynom tail = new Polynom(0, 0);

123456Monom polPointer = tail.head;

123456while (pointer != null) {

123456123456if (checkZero(pointer.kf)) {

123456123456tail.add(pointer.p, pointer.kf, polPointer);

123456polPointer = polPointer.next;}

pointer = pointer.next;}

return tail.head.next;}

public double gorner(double x) {

123456Monom h = head;

123456Monom prev = head;

123456Mdouble res = 0;

123456123456Mwhile (h != null) { //пока есть мономы

123456123456Mif (prev.p - h.p <= 1) {

123456Mres = h.kf + x * res;

123456Mprev = h;

h = h.next;

123456Monom h = head;

123456Monom prev = head;

123456Mdouble res = 0;

123456123456Mwhile (h != null) { //пока есть мономы

123456123456Mif (prev.p - h.p <= 1) {

123456Mres = h.kf + x * res;

123456Mprev = h;

h = h.next;

С декабря 2017 года в Google появились запросы по слову DeepFake. Все начиналось вполне прилично: Стэнфордские ученые опубликовали статью о технологии Face2Face и выложили на YouTube фейк-видео с Джорджем Бушем. Мы рассказываем о том, как с тех пор разрослась индустрия, какие есть опасности и как сохранять спокойствие в новой цифровой реальности.

Это достаточно молодая технология, но растёт она бешеными темпами. Согласно исследованию The State of DeepFake 2020, количество дипфейк-видео удваивается каждые 6 месяцев. Если в 2019 году в интернете было доступно 14 тысяч дипфейк-видео, то к 2020 году их стало в 6 раз больше: 85 тысяч видео.

DeepFake – метод создания фейковых изображений с помощью искусственного интеллекта.

Эта технология позволяет заменять лица на видео и генерировать фотографии несуществующих людей.

Эта технология позволяет заменять лица на видео и генерировать фотографии несуществующих людей.

Это достаточно молодая технология, но растёт она бешеными темпами. Согласно исследованию The State of DeepFake 2020, количество дипфейк-видео удваивается каждые 6 месяцев. Если в 2019 году в интернете было доступно 14 тысяч дипфейк-видео, то к 2020 году их стало в 6 раз больше: 85 тысяч видео.

DeepFake – метод создания фейковых изображений с помощью искусственного интеллекта.

Эта технология позволяет заменять лица на видео и генерировать фотографии несуществующих людей.

Эта технология позволяет заменять лица на видео и генерировать фотографии несуществующих людей.

от 14K

до 85K

При этом отличить дипфейк от реальной фотографии уже очень трудно. В интернете есть сервис This Person Does Not Exist, который генерирует изображения несуществующих людей, и они пугающе похожи на настоящих.

Попробуйте угадать, какие фото справа

— реальные, а какие созданы искусственным интеллектом.

Попробуйте угадать, какие фото справа

— реальные, а какие созданы искусственным интеллектом.

1.Реальный человек — слева.

Справа — дипфейк.

Справа — дипфейк.

2.Это два дипфейка. Этих людей не существует, их придумал искусственный интеллект.

Угадать не получается даже у продвинутых пользователей.

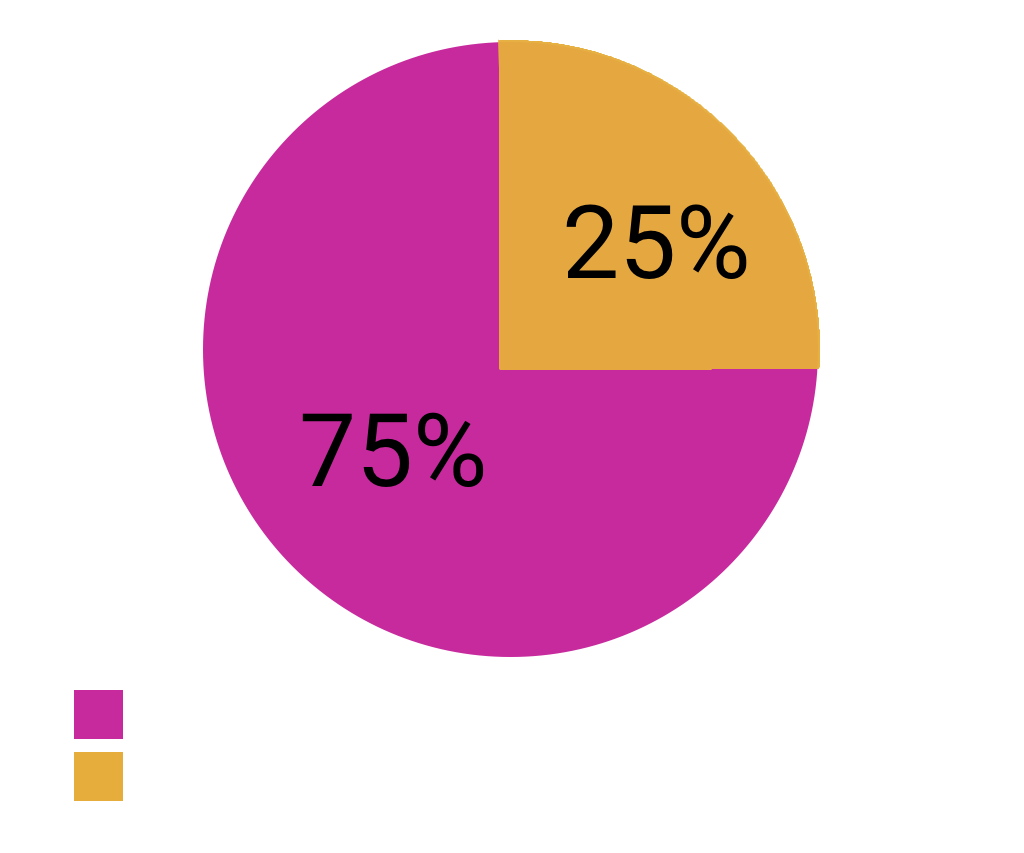

В журнале «Код» для начинающих программистов существует рубрика #дипфейкрадар, в рамках которой читателям показывают две фотографии и просят определить, где дипфейк. Несмотря на то, что целевая аудитория журнала — технически подкованные пользователи, правильно отвечают лишь 25%.

В журнале «Код» для начинающих программистов существует рубрика #дипфейкрадар, в рамках которой читателям показывают две фотографии и просят определить, где дипфейк. Несмотря на то, что целевая аудитория журнала — технически подкованные пользователи, правильно отвечают лишь 25%.

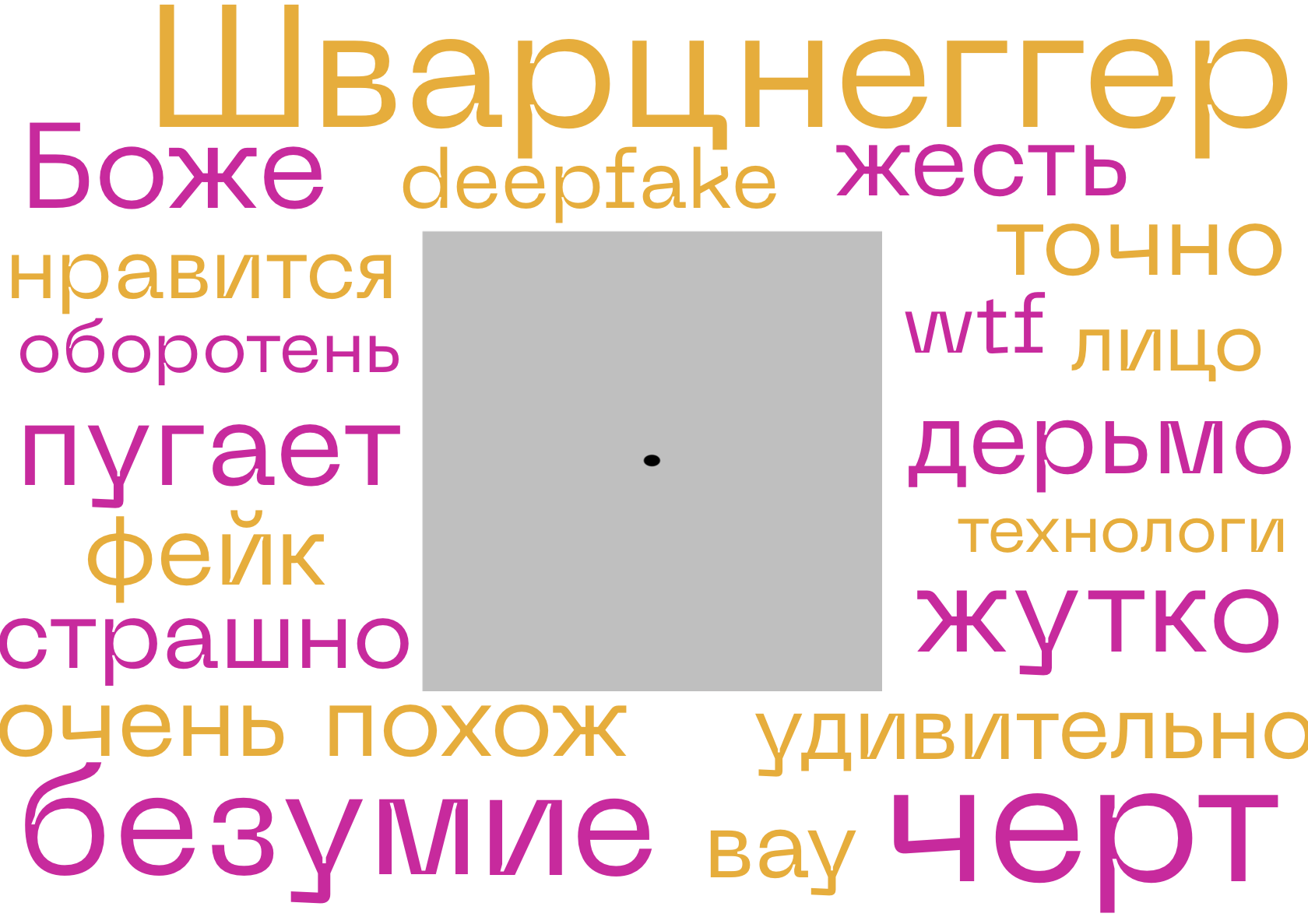

Такая правдоподобность пугает людей.

Согласно опросу Edelman Trust Barometer 2020, 66% опрошенных переживают, что из-за технологий мы перестанем понимать, где реальность, а где — неправда.

Беспокойство пользователи высказывают и в комментариях под популярными дипфейк — видео.

Согласно опросу Edelman Trust Barometer 2020, 66% опрошенных переживают, что из-за технологий мы перестанем понимать, где реальность, а где — неправда.

Беспокойство пользователи высказывают и в комментариях под популярными дипфейк — видео.

Сейчас в связи с DeepFake существует две реальные проблемы.

Первая — это угроза политическому

имиджу и национальной безопасности.

Например, в ходе выборов в 2020 году в Америке кандидат от демократов сделал шутливый ролик с использованием технологии про своего оппонента — республиканца. Он, якобы, выступил со смешными заявлениями: «Знаете, почему я ненавижу Барака Обаму? Потому что он круче меня. Он такой жесткий, каким я только пытаюсь быть. Я не могу отрастить бороду».

имиджу и национальной безопасности.

Например, в ходе выборов в 2020 году в Америке кандидат от демократов сделал шутливый ролик с использованием технологии про своего оппонента — республиканца. Он, якобы, выступил со смешными заявлениями: «Знаете, почему я ненавижу Барака Обаму? Потому что он круче меня. Он такой жесткий, каким я только пытаюсь быть. Я не могу отрастить бороду».

Более зловещие ролики запустила антикоррупционная компания RepresentUs. На одном весьма реалистичный Владимир Путин обсуждал падение демократии в Америке, а на другом — об этом говорил Ким Чен Ын.

Однако сейчас эти кейсы не доставляют серьезных неприятнойстей. Во-первых, сами создатели делают видео очевидно ироничными и не скрывают подделки. Во-вторых, власти владеют технологиями распознавания, о которых мы еще расскажем.

Однако сейчас эти кейсы не доставляют серьезных неприятнойстей. Во-первых, сами создатели делают видео очевидно ироничными и не скрывают подделки. Во-вторых, власти владеют технологиями распознавания, о которых мы еще расскажем.

Вторая угроза касается простых людей.

А точнее женщин.

А точнее женщин.

Это распространение порно-контента на основе данных. В 2019 году количество фейк-порно составляло 96% от общей массы дипфейков. Все они включали в себя обработку лишь женских персонажей. Такие события оставляют неприятные последствия в жизни девушек. Например, своей историей поделилась индийская журналистка и активистка Рана Айюб.

В 2018 году она публично выступила с политическими заявлениями и спустя некоторое время видео с её дипфейком разлетелось в сети.

Так заинтересованные лица хотели ограничить её влияние в публичном пространстве. «Я просто не могла выйти на улицу. (...) Люди думали, что теперь они могут делать со мной все, что захотят», — призналась девушка в своём материале.

Так заинтересованные лица хотели ограничить её влияние в публичном пространстве. «Я просто не могла выйти на улицу. (...) Люди думали, что теперь они могут делать со мной все, что захотят», — призналась девушка в своём материале.

Реальные решения!

Поскольку «на глаз» определить дипфейк трудно, исследователи разрабатывают алгоритмы, которые обнаруживают подделки.

В сентябре 2019 года Facebook запустила конкурс Deepfake Detection Challenge (DFDC), в рамках которого разработчики создают решения по распознаванию дипфейков с использованием искусственного интеллекта. С каждым месяцем на DFDC присылали всё более точные алгоритмы.

С января по март 2020 года ошибки в предсказании уменьшились на 0,5 единиц. Лучшее решение по итогам DFDC обнаруживала дипфейк с вероятностью 82%. В июне 2020 года соревнование закончилось.

Данные:

Данные:

С фотографиями всё ещё проще.

В марте 2021 года учёные из США разработали инновационный метод обнаружения дипфейков на изображениях. Новый алгоритм сравнивает свет, отражённый в глазах.

На фотографии реального человека, отражение в двух глазах будет одинаковым, потому что они видят одно

и то же.

На фотографии реального человека, отражение в двух глазах будет одинаковым, потому что они видят одно

и то же.

Изображения, сгенерированные нейросетями, обычно не могут точно передать это сходство. Точность такого подхода — 94%.

Дипфейки с каждым годом становятся правдоподобнее, но и светлая сторона интернета не спит. Развитие алгоритмов обнаружения дипфейков не позволит подделкам захватить мир.

We Are Cute:)

- Сабурова ДаринаDesigner

- Нога СофияJournalist

- Борисов АндрейJournalist

Заставка: https://www.youtube.com/watch?v=oxXpB9pSETo

Дипфейк Джорджа Буша: https://www.youtube.com/watch?v=ohmajJTcpNk

Дипфейк В.Путина: https://www.youtube.com/watch?v=y3DhOkli2vA&ab_channel=crookedpixel_ru

Дипфейк Королевы Виктории: https://www.youtube.com/watch?v=IvY-Abd2FfM&ab_channel=Channel4

Коллаж дипфейков: https://www.youtube.com/watch?v=9pCGV30Lt88&ab_channel=Geocatapat

Дипфейк Арнольда Шварцнейгера: https://www.youtube.com/watch?v=bPhUhypV27w&t=13s&ab_channel=CtrlShiftFace

Дипфейк республиканца Мэтта Гетца: https://www.youtube.com/watch?v=Y6HKo-IAltA

Дипфейк В.Путина: https://www.youtube.com/watch?v=sbFHhpYU15w

Дипфейк Ким Чен Ын: https://www.youtube.com/watch?v=ERQlaJ_czHU

Дипфейк мистера Бина: https://www.youtube.com/watch?v=tDAToEnJEY8&ab_channel=crookedpixel

Дипфейк Джорджа Буша: https://www.youtube.com/watch?v=ohmajJTcpNk

Дипфейк В.Путина: https://www.youtube.com/watch?v=y3DhOkli2vA&ab_channel=crookedpixel_ru

Дипфейк Королевы Виктории: https://www.youtube.com/watch?v=IvY-Abd2FfM&ab_channel=Channel4

Коллаж дипфейков: https://www.youtube.com/watch?v=9pCGV30Lt88&ab_channel=Geocatapat

Дипфейк Арнольда Шварцнейгера: https://www.youtube.com/watch?v=bPhUhypV27w&t=13s&ab_channel=CtrlShiftFace

Дипфейк республиканца Мэтта Гетца: https://www.youtube.com/watch?v=Y6HKo-IAltA

Дипфейк В.Путина: https://www.youtube.com/watch?v=sbFHhpYU15w

Дипфейк Ким Чен Ын: https://www.youtube.com/watch?v=ERQlaJ_czHU

Дипфейк мистера Бина: https://www.youtube.com/watch?v=tDAToEnJEY8&ab_channel=crookedpixel